目录

不同版本的deepseek-r1蒸馏模型,在MacMini M4 24G上使用ollama本地部署,跑起来到底能有多快?最高能跑到多大的模型?

下面用仿造岳阳楼记写一篇圆明园来做测试:

请模仿岳阳楼记写一篇圆明园,表达只有自身强大才能不被人欺负

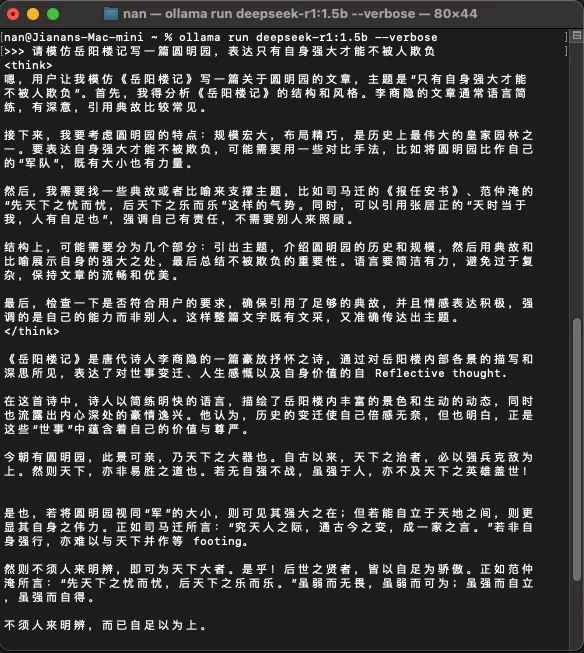

deepseek-r1:1.5b模型

输出效果:

运行速度:

total duration: 9.237065417s load duration: 26.694583ms prompt eval count: 22 token(s) prompt eval duration: 680ms prompt eval rate: 32.35 tokens/s eval count: 647 token(s) eval duration: 8.529s eval rate: 75.86 tokens/s

1.5b模型的速度简直快到飞起!但是,效果嘛……非常差!大概小学生作文水平,夹杂着大量的胡说八道,基本上是不能用的。

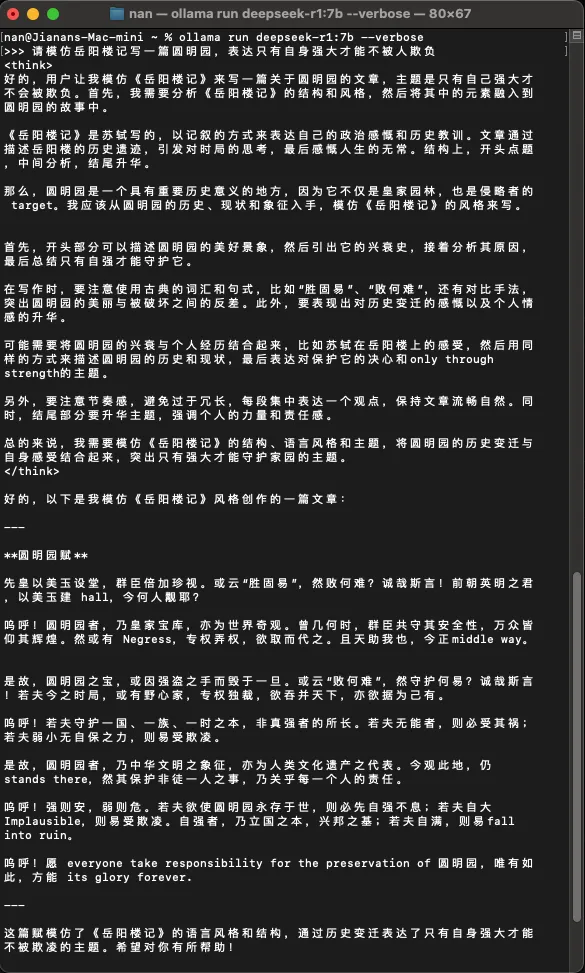

deepseek-r1:7b模型

输出效果:

运行速度:

total duration: 41.597948209s load duration: 26.073667ms prompt eval count: 22 token(s) prompt eval duration: 2.803s prompt eval rate: 7.85 tokens/s eval count: 793 token(s) eval duration: 38.766s eval rate: 20.46 tokens/s

7b模型在运行速度上也不慢!效果比1.5b模型要好得多,但还是会胡说八道。搞错了《岳阳楼记》的作者,输出的内容中英混杂,同样是不可用的状态。

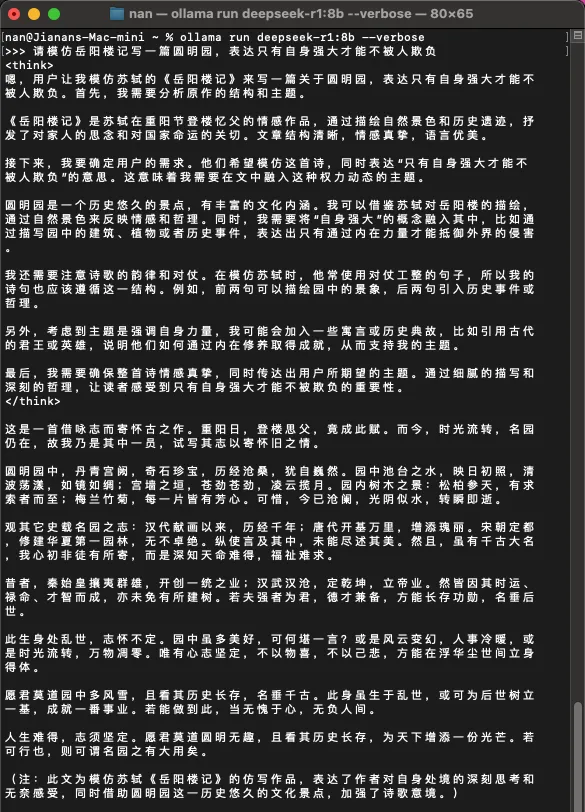

deepseek-r1:8b模型

输出效果:

运行速度:

total duration: 58.62961975s load duration: 27.202041ms prompt eval count: 30 token(s) prompt eval duration: 3.159s prompt eval rate: 9.50 tokens/s eval count: 1062 token(s) eval duration: 55.441s eval rate: 19.16 tokens/s

8b模型的速度与7b的基本一致。输出的效果也好一点,起码没有中英混杂了。不过,一样是搞错了《岳阳楼记》的作者。小模型在训练数据的广度上,还是差了一点。

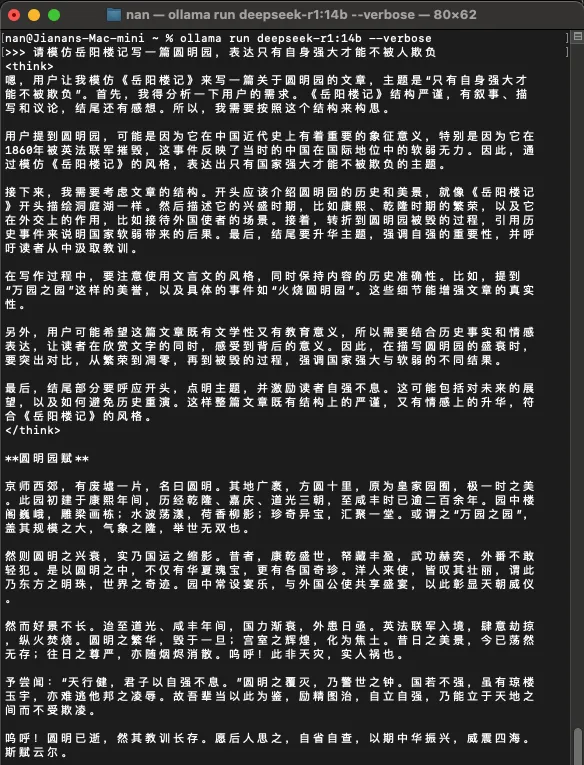

deepseek-r1:14b模型

输出效果:

运行速度:

total duration: 1m27.703764166s load duration: 24.051708ms prompt eval count: 22 token(s) prompt eval duration: 5.605s prompt eval rate: 3.93 tokens/s eval count: 843 token(s) eval duration: 1m22.073s eval rate: 10.27 tokens/s

14b模型的速度,开始就肉眼变慢了,大概只有8b模型的一半,不过也还在能接受的范围内。但,思考过程的逻辑性,以及最终输出的质量有了大幅度的上升,开始有岳阳楼记那个味道了。

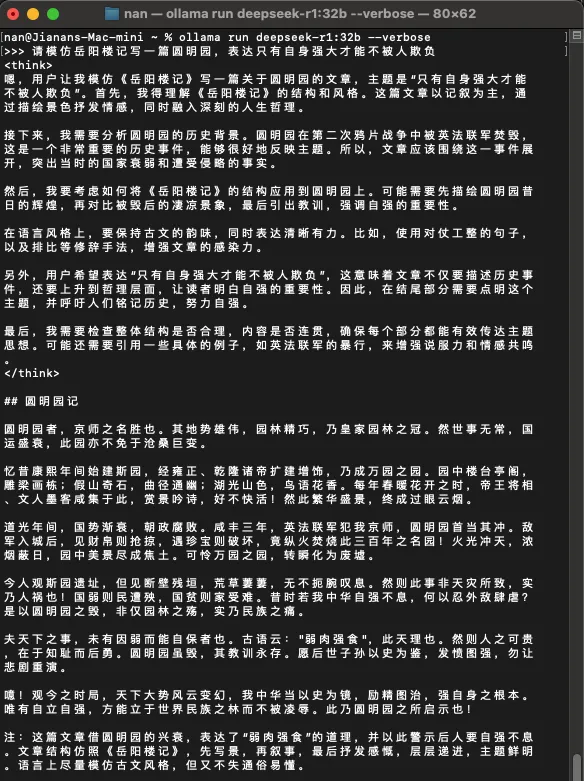

deepseek-r1:32b模型

输出效果:

运行速度:

total duration: 6m43.596812s load duration: 28.304875ms prompt eval count: 22 token(s) prompt eval duration: 1m14.966s prompt eval rate: 0.29 tokens/s eval count: 864 token(s) eval duration: 5m28.597s eval rate: 2.63 tokens/s

到32b模型这里,模型的加载速度非常慢,输出速度基本上是逐字逐字吐出。而且,24G的统一内存明显不够用了,运行32b模型期间,稍微多开几个软件就会导致整个系统卡顿,完全没法做生产力。至于输出的效果嘛,那是真的好太多了。整个推理思考的过程都很准确,仿写的文章也很到位。

总结

在max mini m4 24G内存这个配置上,14b以下的蒸馏模型速度很快效果差,除非是特定工作流和领域使用,否则一般使用的价值不大。32b模型的效果最好,但速度奇慢,没有作为生产力的价值。32b再往上的模型,这个配置就不用想了,还是放过它吧……

综合速度和效果,在这个配置上,唯有14b的模型可以本地部署用用。

本文作者:Jianan

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 © 2012-2025 Jianan 许可协议。转载请注明出处!