前阵子用Ollama玩deepseek本地部署的,是不是玩得很开心啊?坏消息,Ollama刚刚被官方通报存在安全风险……是不是感觉天要塌了?

别紧张,情况实际没那么严重,大部分人还是很安全的。

看下官方的通报:

总结起来,有两个问题。

-

Ollama在本地部署大模型的时候,会在本地启动一个web服务,并默认开放11434端口。但是呢,这个web服务没有做任何访问限制。如果这个web服务被暴露在公网,那么任何人都能够随意使用你的AI大模型,甚至可能导致数据泄露。

-

Ollama存在历史漏洞,可能会被用来攻击。

先说历史漏洞这个问题,只要你用最新的Ollama版本就不用太担心这个问题,基本都是修复了。所以,安不安全,主要看第一个问题:你的Ollama服务,能不能在公网上随意访问?俗称,“裸奔”!

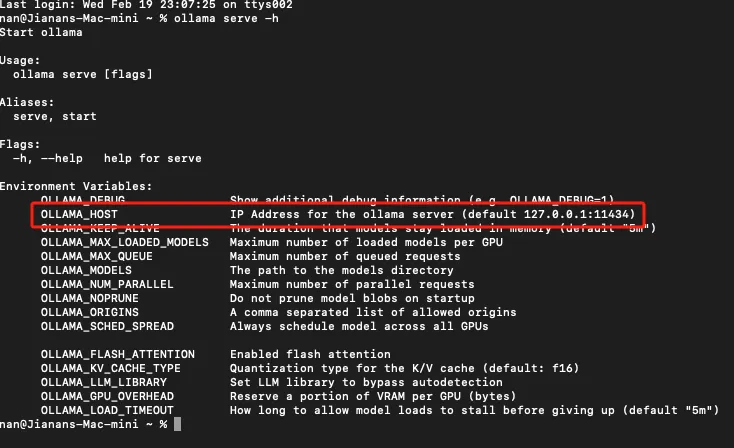

我看了下Ollama的服务默认配置:

嗯?Ollama的web服务默认部署在127.0.0.1IP地址上。而127.0.0.1是个特殊的IP地址,属于回环地址,主要用于计算机内部的网络通信。部署在127.0.0.1这个地址上的web服务,只能本机访问,外部是访问不到的。

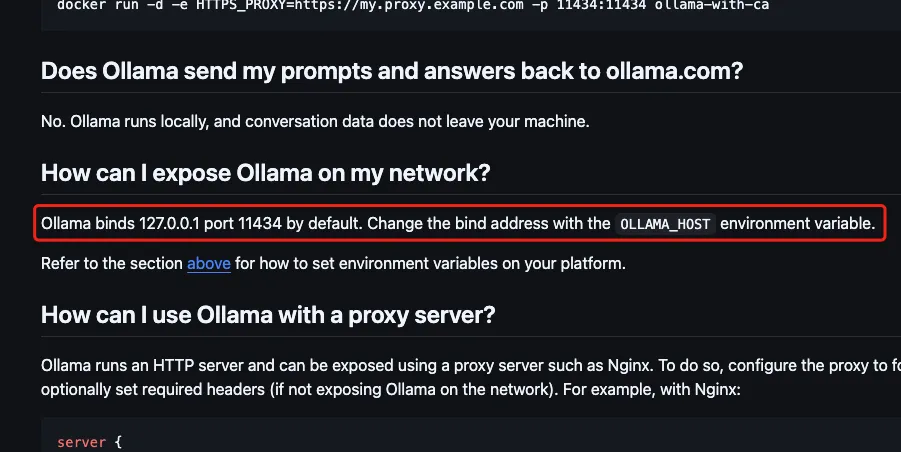

我又去翻了下Ollama的文档,再确认了一下:

Ollama的web服务,确实是默认部署在127.0.0.1IP地址和11434端口上的。如果想要修改部署的ip,让公网也能访问的话,还比较麻烦,得去设置名为OLLAMA_HOST的系统环境变量。实际上,大部分人都不会去改动到这个环境变量。一般使用都是从Ollama官网下载后,直接本地部署运行大模型。也就是说,如果你没有修改过OLLAMA_HOST变量,那么你就是安全的。这事跟你没啥关系,放心用吧!

但是也要说回来,如果你修改过OLLAMA_HOST环境变量(比如改为0.0.0.0),又或者你的Ollama是用docker容器部署的,并且还真就那么巧,你的机器还有公网IP(一般家庭宽带都没有公网IP)。那……你还是赶紧处理一下吧,你的Ollama已经在公网上“裸奔”了!可以把环境变量改回来,或者加一下防火墙,只要能限制公网访问就行。

本文作者:Jianan

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 © 2012-2025 Jianan 许可协议。转载请注明出处!